Bevezetés: A Felhőtől a Zsebedig

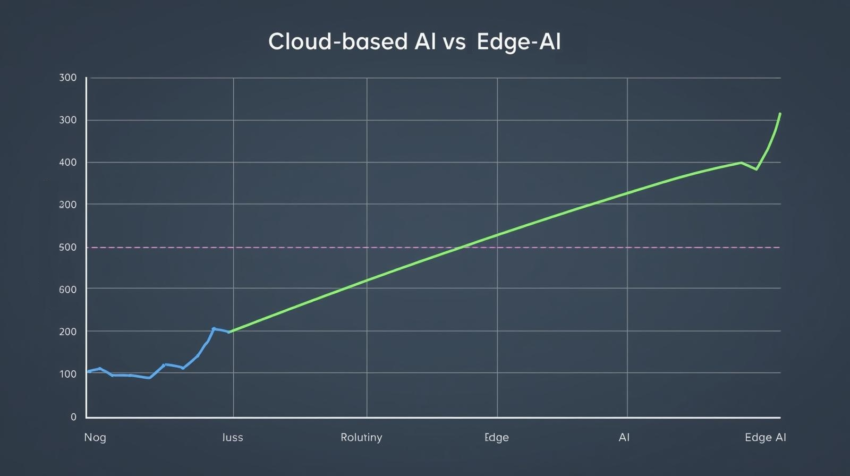

A Generatív Mesterséges Intelligencia (MI) eddig nagyrészt a felhőben élt. Minden promptot, minden kérésünket egy távoli adatközpontba kellett küldeni feldolgozásra, ami késleltetést, költségeket és adatvédelmi aggályokat okozott.

A Generatív Edge AI (más néven On-Device AI) az a technológiai váltás, amely során az MI-modelleket (beleértve a nagy nyelvi modelleket, az LLM-eket) közvetlenül a végfelhasználói eszközön (okostelefon, laptop, okosóra) futtatjuk, elkerülve a felhőalapú szervereket.

Ez a 41. napon vizsgált áttörés teszi lehetővé a valós idejű, rendkívül személyre szabott és maximális adatvédelmet garantáló MI-alkalmazásokat, megnyitva az utat a mindennapi, diszkrét MI-asszisztensek felé.

I. A Technológiai Lépés: Miért Kritikus az Edge AI?

Három alapvető ok magyarázza, miért szükséges az MI-t a peremre (Edge) vinni.

1. Késleltetés (Latency) és Sebesség

A felhőbe küldött kérésekhez idő kell: a jelnek fel kell utaznia a szerverhez, feldolgozódnia kell, majd vissza kell térnie.

- Valós idejű Interakció: Ha az MI egy telefonos hívást vagy egy futó edzést akar valós időben elemezni, a mikroszekundumok is számítanak. Az On-Device AI eliminálja ezt a késleltetést, mivel a számítási folyamat a felhasználó kezében történik. Ez elengedhetetlen a gyors és folyamatos felhasználói élményhez.

2. Adatvédelem (Privacy)

Ez az Edge AI egyik legnagyobb vonzereje, különösen az EU szigorú adatvédelmi szabályozása (GDPR) mellett.

- Helyi Feldolgozás: Mivel a Generatív MI-modell közvetlenül az eszközön dolgozza fel a felhasználói bemenetet (pl. egy üzenetet, egy személyes naptárbejegyzést), a szenzitív adatok soha nem hagyják el a telefont. Ez garantálja a maximális adatvédelmet. Gondoljunk csak a helyi összefoglalókra, vagy a privát chat-válaszok generálására.

3. Költséghatékonyság

A felhőalapú MI-szolgáltatások futtatása és skálázása rendkívül drága a szolgáltatók számára (nagy energiaigényű GPU-k).

- Energia- és Számítási Megtakarítás: Ha a felhasználók saját eszközeik számítási kapacitását használják, azzal drasztikusan csökken a felhőszolgáltatók terhelése és költsége.

II. A Generatív LLM-ek Helyi Futtatásának Kihívásai

A hagyományos nagy nyelvi modellek több száz milliárd paraméterrel rendelkeznek, így a futtatásukhoz több tucat szerverre van szükség. Egy telefon korlátozott memóriával és kisebb, de optimalizált chipkészlettel rendelkezik.

1. Modellméret Redukció és Kvantálás

A kihívás az, hogy a modellt kisebbé tegyük, de a teljesítményét megőrizzük.

- Kvantálás (Quantization): Ez a legfontosabb technika. A tréning során a modell súlyait (paramétereit) gyakran 32 bites lebegőpontos számokkal tárolják. A kvantálás során ezeket az információkat tömörítik (pl. 8, 4, vagy akár 2 bites egészekre). Ez drasztikusan csökkenti a modell méretét és a szükséges memóriát anélkül, hogy jelentősen romlana a válasz minősége.

- Modell Párlás (Distillation): Egy nagyobb, tanult modellt (tanárt) arra használnak, hogy megtanítsanak egy sokkal kisebb modellt (diákot), hogyan adjon hasonlóan jó válaszokat.

2. Dedikált Hardver: NPU és Tensor Magok

Az okostelefon-gyártók ma már speciális chipeket (Neural Processing Units, NPU) építenek be az eszközökbe.

- Optimalizált Számítás: Az NPU-kat kifejezetten az MI-feladatokhoz tervezték (pl. mátrixműveletekhez), így sokkal energiatakarékosabbak és gyorsabbak az LLM-ek futtatásában, mint a hagyományos CPU-k vagy GPU-k.

III. Kiemelt Példák: Gemini Nano és Apple Intelligence

A technológiai óriások már bevezették az Edge AI-t a gyakorlatba.

1. Google Gemini Nano

A Gemini család legkisebb, kifejezetten On-Device futtatásra optimalizált modellje.

- Alkalmazások: Közvetlenül a telefonon képes összefoglalni a felvett hangfelvételeket vagy a chat-konverziókat. Képes válaszokat generálni a csevegőalkalmazásokban, anélkül, hogy ehhez internetkapcsolatra lenne szükség.

2. Apple Intelligence

Az Apple saját Edge AI keretrendszere, amely az adatvédelmet helyezi abszolút előtérbe.

- Private Cloud Compute: A rendszer először a telefonon próbálja feldolgozni a feladatot. Csak akkor küld el minimális adatot a felhőbe, ha a feladat túl komplex, de ekkor is egy átlátható és szigorúan titkosított “privát felhőbe”.

Összegzés: Az Ubiquitus AI Jövője

Az Edge AI átalakítja a Generatív MI-t egy felhőalapú szolgáltatásból személyes, mindenütt jelenlévő asszisztenssé. Ez a váltás nemcsak a sebességet és a költséghatékonyságot növeli, hanem forradalmasítja az MI-vel való interakciónk legalapvetőbb aspektusát: a bizalmat.

Azáltal, hogy a modell a mi eszközünkön dolgozik, az MI végre valóban a mi személyes, privát tudásunk kezelőjévé válhat. A jövő nem a távoli szervereké, hanem a zsebünkben lévő szuperintelligenciáé.

2 thoughts on “Edge AI és az Okoseszközök: A Generatív AI Futtatása Telefonon és Okosórákon (On-Device AI)”