Bevezetés: A gombok a motorháztető alatt

Eddig a sorozatban főként azzal foglalkoztunk, mit mondjunk az MI-nek (prompting), és mire használjuk. De ahogy egy profi fotós sem csak automata módban használja a gépét, úgy egy profi MI-felhasználónak is ismernie kell azokat a “tekerőgombokat”, amelyekkel a modell viselkedését szabályozhatja.

A nagy nyelvi modellek (LLM) nem csak véletlenszerűen dobálják egymás után a szavakat. Egy valószínűségi alapon működő gépezetről van szó, amelynek a szigorúságát vagy éppen a csapongó kreativitását mi magunk is beállíthatjuk. A mai napon a két legfontosabb paramétert, a Hőmérsékletet (Temperature) és a Top-P értéket vesszük górcső alá.

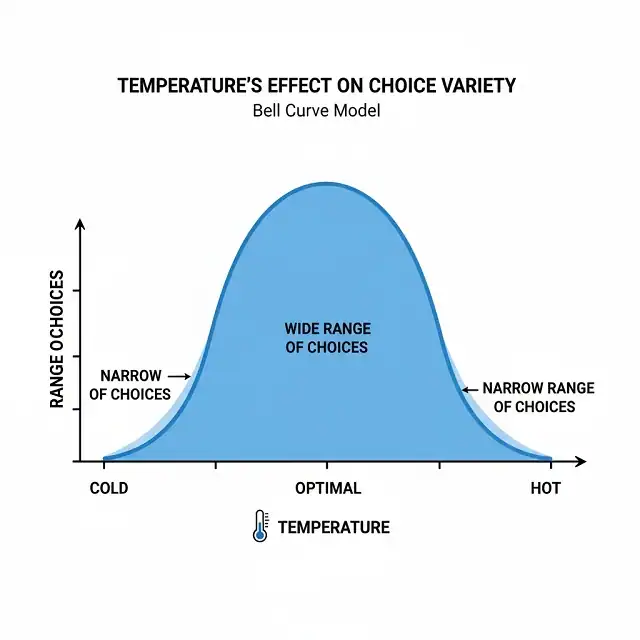

I. A Hőmérséklet (Temperature): A kreativitás termosztátja

A hőmérséklet az a paraméter, amely meghatározza, hogy a modell mennyire legyen “kalandvágyó” a következő szó kiválasztásakor.

- Alacsony hőmérséklet (0.1 – 0.3): A modell a legvalószínűbb szavakat választja. A válaszok precízek, tényszerűek és ismételhetőek lesznek. Ideális programozáshoz, adatkinyeréshez vagy tényeken alapuló összefoglalókhoz.

- Közepes hőmérséklet (0.5 – 0.7): Ez az arany középút. Van benne egy kis váratlanság, de a logika még szoros. Általános beszélgetésekhez és cikkíráshoz ezt javasoljuk.

- Magas hőmérséklet (0.8 – 1.2+): A modell elkezdi a kevésbé valószínű szavakat is beválogatni. A válaszok kreatívak, költőiek, de néha kaotikusak vagy “hallucinációkra” hajlamosak lesznek. Kiváló történetmeséléshez vagy brainstorminghoz.

II. Mi az a Top-P (Nucleus Sampling)?

A Top-P (vagy más néven Nucleus Sampling) egy másik módja a modell válogatási folyamatának korlátozására. Itt nem a valószínűséget skálázzuk, hanem a szavak “halmazát” szűkítjük le.

- Ha a Top-P értéke 0.1, az MI csak azokból a szavakból válogat, amelyek együttesen a legfelső 10%-nyi valószínűségi tartományba esnek. Ez nagyon koncentrált és logikus kimenetet eredményez.

- Ha a Top-P értéke 1.0, akkor az összes lehetséges szót figyelembe veszi (ez az alapértelmezett).

III. Hogyan állíthatjuk be a mesterséges intelligencia paramétereit a pontosabb és kreatívabb válaszok érdekében?

A gyakorlatban a legtöbb felhasználó az OpenAI “Playground” felületén vagy API-n keresztül találkozik ezekkel a beállításokkal. Íme a recept a különböző feladatokhoz:

- Műszaki dokumentáció írása: * Temperature: 0.2

- Top-P: 0.1

- Eredmény: Száraz, de tűpontos szöveg.

- Marketing szlogenek generálása:

- Temperature: 0.8

- Top-P: 0.9

- Eredmény: Szokatlan szófordulatok, figyelemfelkeltő ötletek.

- Kódban lévő hiba javítása (Debugging):

- Temperature: 0

- Top-P: 1

- Eredmény: A leglogikusabb, leginkább determinisztikus megoldás.

IV. Egyéb fontos paraméterek (Röviden)

- Max Tokens: Meghatározza a válasz maximális hosszát. Hasznos, ha el akarjuk kerülni a túl hosszúra nyúló válaszokat.

- Presence Penalty: Megakadályozza, hogy az MI túl sokszor ismételje ugyanazokat a témákat. Növeli a válasz sokszínűségét.

- Frequency Penalty: Csökkenti annak az esélyét, hogy ugyanazokat a szavakat vagy kifejezéseket lássuk újra és újra.

Összegzés

Az MI paramétereinek megértése választóvonal az amatőr és a profi felhasználó között. Ha tudod, hogyan kell “lehűteni” a modellt a precízió érdekében, vagy “felmelegíteni” a kreativitáshoz, akkor az MI nem csak egy chatbot lesz a kezedben, hanem egy finomhangolt precíziós műszer.